So basteln sich Firmen ihre Unternehmens-KI

Unterdessen bekommen KI- und Cloud-Giganten wie Microsoft, Amazon, Google, Alibaba und IBM einen weiteren, womöglich mächtigen Konkurrenten. Dazu am Ende dieses heute ausführlichen Newsletters mehr.

Integration von KI in Unternehmensprozesse

Es geht um nicht weniger als den heiligen Gral der KI-Modelle: bequem auffindbares Unternehmenswissen, das das Unternehmen garantiert nicht verlässt. „Welcher unserer Standorte hat im Verhältnis zu der Anzahl der Mitarbeiter den geringsten Umsatz erzielt?“ Das wäre eine denkbare Frage, die früher mithilfe von Excel und einem funktionierenden Controlling beantwortet werden konnte und künftig von einem internen ChatGPT in menschlicher Sprache abgefragt werden könnte.

Microsofts Beitrag zur KI-Technologie

Diese Verknüpfung von KI mit internen Unternehmensdaten ist vermutlich eine der Schlüsseltechnologien der kommenden Monate und Jahre.

Microsoft als Geldgeber hinter dem KI-Platzhirschen OpenAI mit ChatGPT hat die KI-Technik vor Kurzem in seine Azure-Cloud-Software eingebaut und jetzt zum allgemeinen Aufsetzen eigener Anwendungen für IT-Abteilungen freigeschaltet. Das hilft Unternehmen, interne Unterlagen und Geschäftsgeheimnisse im eigenen Haus zu behalten – was regelmäßig schiefgehen könnte, wenn Mitarbeiterinnen und Mitarbeiter beim herkömmlichen ChatGPT mit künstlicher Intelligenz quatschen. Ein kommerzielles KI-Angebot von Microsoft an die Unternehmen belässt zudem ergänzende interne und wahrscheinlich vertrauliche Daten auf den von Unternehmen angemieteten Servern – wahlweise auch auf Servern in Deutschland.

Begrenzungen und Möglichkeiten der Bots

Nicht zu verwechseln ist Microsofts Azure-KI mit den sogenannten Power Virtual Agents von Microsoft – einem weiteren Produkt, das das US-Unternehmen nun anbietet. Das sind Bots, die Microsoft-Kunden zum Beispiel für ihre Kundenbetreuung über ihre Website erstellen können. Die Maschine verwendet dann die öffentlich zugänglichen Informationen der Website. Sie beantwortet etwa Fragen wie „Was sind Ihre Öffnungszeiten?“ Erst, wenn zusätzliche eigene interne Quellen verwendet werden sollen, kommt die Azure-Cloud-Software ins Spiel. Bislang sind die Power Virtual Agents auf die US-Region und die englische Sprache begrenzt.

Irrtümer über das Lernen der KI

Ein allgemeiner Irrtum ist, dass die KI automatisch aus allen Prompteingaben, aus hochgeladenen Geschäftsplänen in Excel-Dateien oder auch nur aus korrigierenden Prompts dauerhaft lernt. Die Maschine lernt „nur“ für die Dauer einer Sitzung aus vorangegangenen Eingaben des jeweiligen Nutzers und nur für diese Person. Startet man eine neue Sitzung, ist das in der vergangenen Sitzung erlernte Wissen futsch.

Es wäre allerdings auch ein starkes Stück, würde das Sprachmodell fehlerhafte oder bösartig eingebaute Fehler aus der Nutzerschaft für bare Münze nehmen.

Trainingsdaten und Zuverlässigkeit

Stattdessen greifen die Modelle auf riesige Sätze von geprüften Trainingsdaten zurück. Die können zwar auch fehlerhafte Daten enthalten, etwa aus der Wikipedia, doch haben die KI-Hersteller Methoden entwickelt, überwiegend glaubhafte Quellen fürs Training zu nutzen. Dazu gehören Patentanmeldungen, kategorisierte und für hochwertig angesehene Websites von Zeitungen und Online-Diensten, aber auch scribd.com, das Netflix für Bücher. Dies gilt zumindest für die KI von Google, Bard. Die populärere OpenAI-Anwendung ChatGPT hat seine Trainingsdaten geheim gehalten.

Anforderungen an KI im Unternehmenskontext

Für Unternehmen und Behörden reichen die bisher entstandenen KIs und ihre Antwortqualität in den allgemein zugänglichen Diensten wie ChatGPT oft nicht aus.

Für eine schnelle Zusammenfassung eingereichter Texte, für Überschriftenvorschläge und Social-Media-Beiträge mag die Technik neue Effizienz schaffen. Und auch das schnelle Marketingkonzept oder durchaus kluge Ideenskizzen lassen sich durch KI generieren. Das letzte Wort muss bei gegenwärtigen Stand stets der Mensch haben.

Separate Prüfung und Fine-Tuning

Geht es hart um belastbare Daten, ist eine separate Prüfung erforderlich. Mal ergänzen die Maschinen sich widersprechendes Wissen aus unterschiedlichen Quellen. Mal halluzinieren sie Sachverhalte hinzu, weil sie eine gewisse Wahrscheinlichkeit vermuten. Und auch eine Vielzahl von Diensten wie MottleBot, AskAI, Dante und vielen anderen Chatbots haben es noch nicht geschafft, aus selbst hochgeladenen Daten zuverlässig „die richtigen“ Antworten zu generieren.

Nötig ist deshalb ein sogenanntes Fine-Tuning: Dabei werden eigene Dokumente und Datenbanken in der KI zusätzlich zu den Trainingsdaten vom Hersteller hinterlegt. Das geben MottleBot, AskAI und Co. zwar vor, doch mangelt es oft an der richtigen Aufbereitung dieser zusätzlichen Traingsdaten. In der Folge kommen diese Modell durcheinander.

Anforderungen und Validierung

Wer dies schon einmal getestet hat, wird mit gewissen Anforderungen an die selbst ergänzten Daten konfrontiert. Nötig ist oft ein spezielles Dateiformat, zum Beispiel .json. Und eine Klassifikation gegebener Antworten im Sinne von „Die Maschine hatte leichtes Spiel, hierzu eine Antwort zu finden, denn in den Fine-Tuning-Daten fand sich eine fast gleichlautende Information“.

Hieraus wiederum müsste die frischgebackene KI-Abteilung eines Unternehmens eine Validierung vornehmen, sprich: Von den 100 gegebenen Antworten auf 100 Testfragen waren x falsch beantwortet – also erstellen wir zusätzliche Fine-Tuning-Daten, die die Fehler adressieren und die Maschine anweisen, bestimmte Antworten neu zu formulieren.

Parameter und Kreativität in KI

Auch diese Arbeit stellt noch nicht 100-prozentig fehlerfreie Antworten von KI-Diensten sicher. Aber auf dem Weg dahin ist man.

Zusätzlich kommen bei den bestehenden KIs bestimmte Parameter ins Spiel. So kann man bei OpenAI eine „temperature“ von „0.1“ einfordern – im Grunde möglichst wenig Hitzewallungen: Die Maschine soll nichts erfinden, sich nur an die wahrscheinlichsten Fakten halten. Möchte dagegen jemand eine möglichst phantasievolle Antwort von der KI, etwa den nächsten ungeahnten Schwenk in der Geschichte für eine Romanfigur, käme eine „temperature“ von „0.9“ in Betracht. Das heißt: Es darf jetzt auch abseitig, absurd oder phantasievoll werden.

Möglichkeiten fürs Aufsetzen einer eigenen KI

Fürs Aufsetzen einer eigenen KI gibt es mehrere Möglichkeiten. Denkbar sind unter anderem folgende drei Varianten:

- Nutzung von OpenAI (oder einem anderen Modell) per Verknüpfung mittels API-Technik im Hintergrund

- Nutzung eines lokal heruntergeladenen Large-Language-Models ohne Verknüpfung mit einem kommerziellen Dienst

- Nutzung von ChatGPT über die neue Azure-Server-Umgebung von Microsoft.

Erste Variante: Implementierung und Kosten

Die einfachste erste Variante bestünde in einer internen Webseite, die ähnlichen wie ChatGPT ein Chatformular enthält und im Hintergrund über einen API-Schlüssel den US-Dienst OpenAI befragt – und im kleinen Rahmen gewisse Vorgaben macht wie „Antworte stets auf deutsch.“ So ein Schlüssel kostet ein paar hundertstel US-Cent für jede Anfrage, je nach Länge der Frage und der Antwort.

Die zweite Möglichkeit für eine eigene KI wäre eine eigene GPT-Version auf einem eigenen Server. Die ist womöglich einfacher umgesetzt, als man denkt. Ein eigener Server schreckt Sie ab? Verständlich. Doch hat eine freie Software mittlerweile derart an Qualität zugelegt, dass sie auch vom Otto-Normal-Verbraucher zumindest im Hausnetz oder auch nur auf dem eigenen Windows-PC, dem Mac oder dem Linux-Rechner eingerichtet werden kann.

Zweite Variante: Open-Source-Alternativen

Dazu muss man wissen, dass OpenAI die grundlegenden Daten seines Sprachmodells (Large-Language-Model, LLM) nicht als Open-Source anbietet. Nötig ist stattdessen der besagte API-Key, damit der lokale Server oder Rechner dann bei jeder Abfrage die Schatzkammer von OpenAI in den USA öffnet – und dafür Geld verlangt.

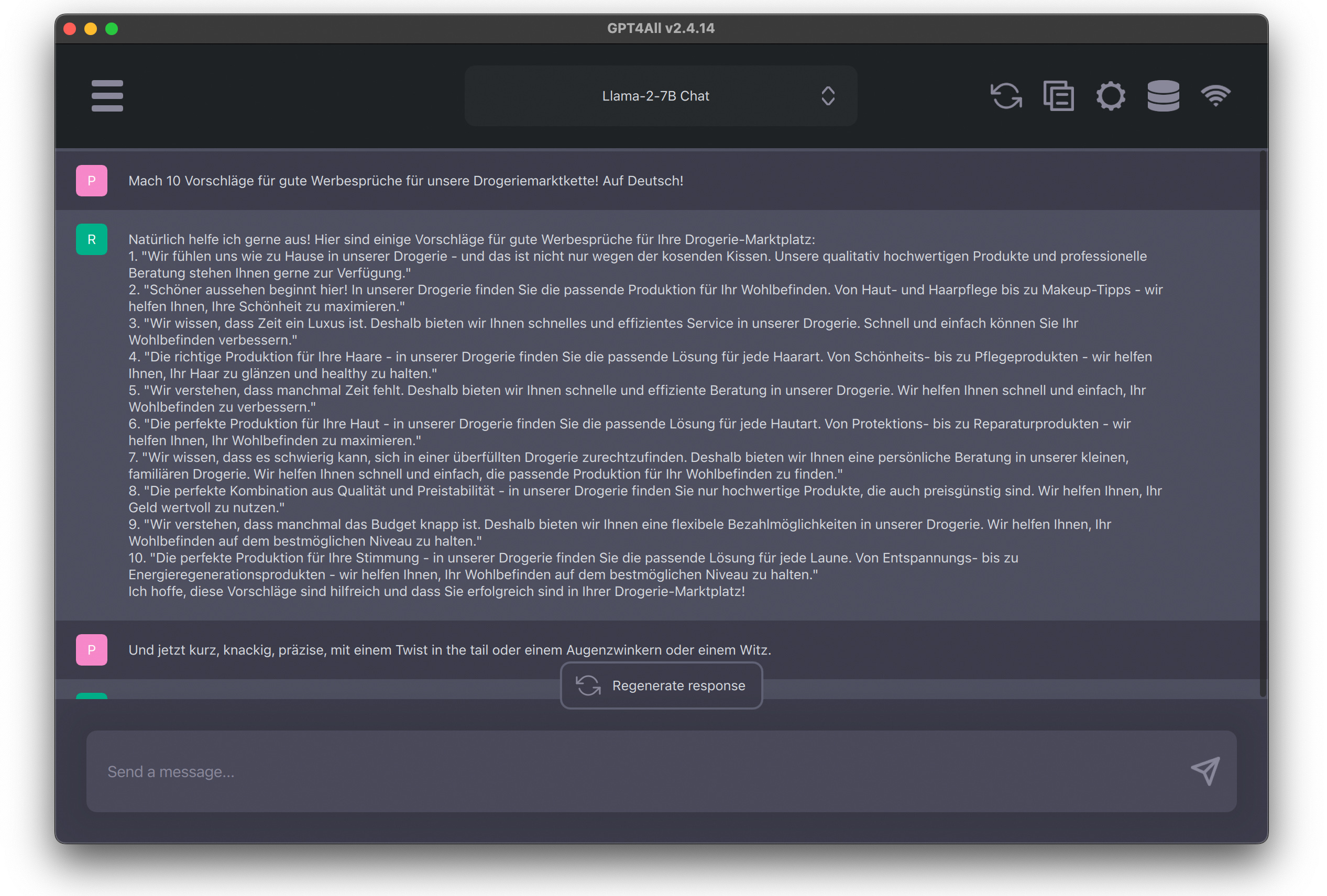

Eine Alternative sind andere LLMs, die als Open Source zur Verfügung stehen. Damit kann man dann eine eigene KI aufsetzen und sie mit zusätzlichen eigenen Dateien bekanntmachen. Wer sich da umsehen möchte: Die freie Software GPT4ALL ermöglicht die lokale Installation eines Chatbots – und anschließend die Auswahl diverser freier LLMs, ohne dass die Maschine in die USA telefoniert. OpenAI, Microsoft und Google bleiben außen vor.

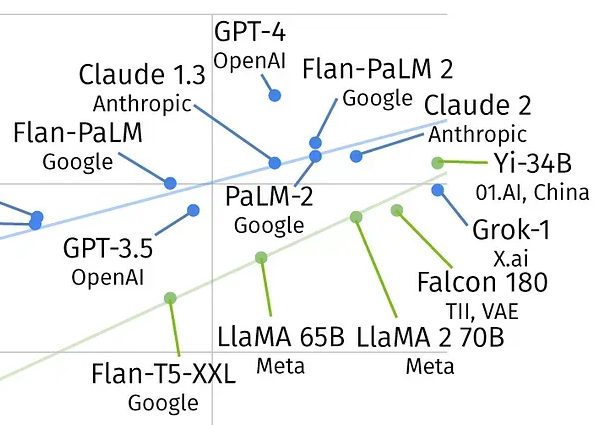

Aufstieg alternativer Chat-Modelle

Diese Modelle tragen dann Namen wie Snoozy (Open-Source), Vicuna (Open-Source) oder Llama-2-7B Chat. Letzteres stammt von Facebook-Anbieter Meta, ist auch kommerziell nutzbar und funktioniert ohne Nach-Hause-Telefonieren zu Facebook. Die Open-Source-Modelle und das von Facebook antworten qualitativ noch nicht so gut wie ChatGPT. Aber sie holen stetig auf. Das erkennt offenbar auch Google an: „Wir brauchen die mehr als sie uns“, heißt es in einem geleakten Dokument über die Open-Source-Gemeinde in Sachen KI.

Die Programmierung der freien Software GPT4ALL hat binnen zwei Monaten so gute Fortschritte gemacht, dass sich die eigene KI binnen einer halben Stunde zusammenklicken lässt.

Schaffung eines Ökosystems für LLMs und KIs

Im Grunde entsteht hier gerade ein Ökosystem für LLMs und KIs, das wie weiland die Wikipedia eine Gefahr für die großen Internet-Player heraufbeschwören könnte. Während OpenAI, Microsoft und Google für viel Geld Trainingsdaten erstellen, stehen über Open-Source die ersten privat zusammengestellten Trainingsdaten bereit. Und zwar solche, die sich ohne kryptische Befehle auf der Konsole, statt dessen über einigermaßen verständliche Fenster zusammenstellen lassen.

Wer möchte ausschließen, dass hier als nächstes Enthusiasten ein verteiltes Modell fürs Generieren von Trainingsdaten erfinden? Verteilt auf viele einzelne Beitragende, die private Rechenzeiten zur Verfügung stellen? Es scheint angesichts der gewonnenen Qualität der Nutzeroberfläche von GPT4ALL, als entstünde dort gerade eine Art KIpedia. Jetzt müssten nur noch möglichst viele die möglichst vielen Inhalte für die Trainingsdaten beitragen.

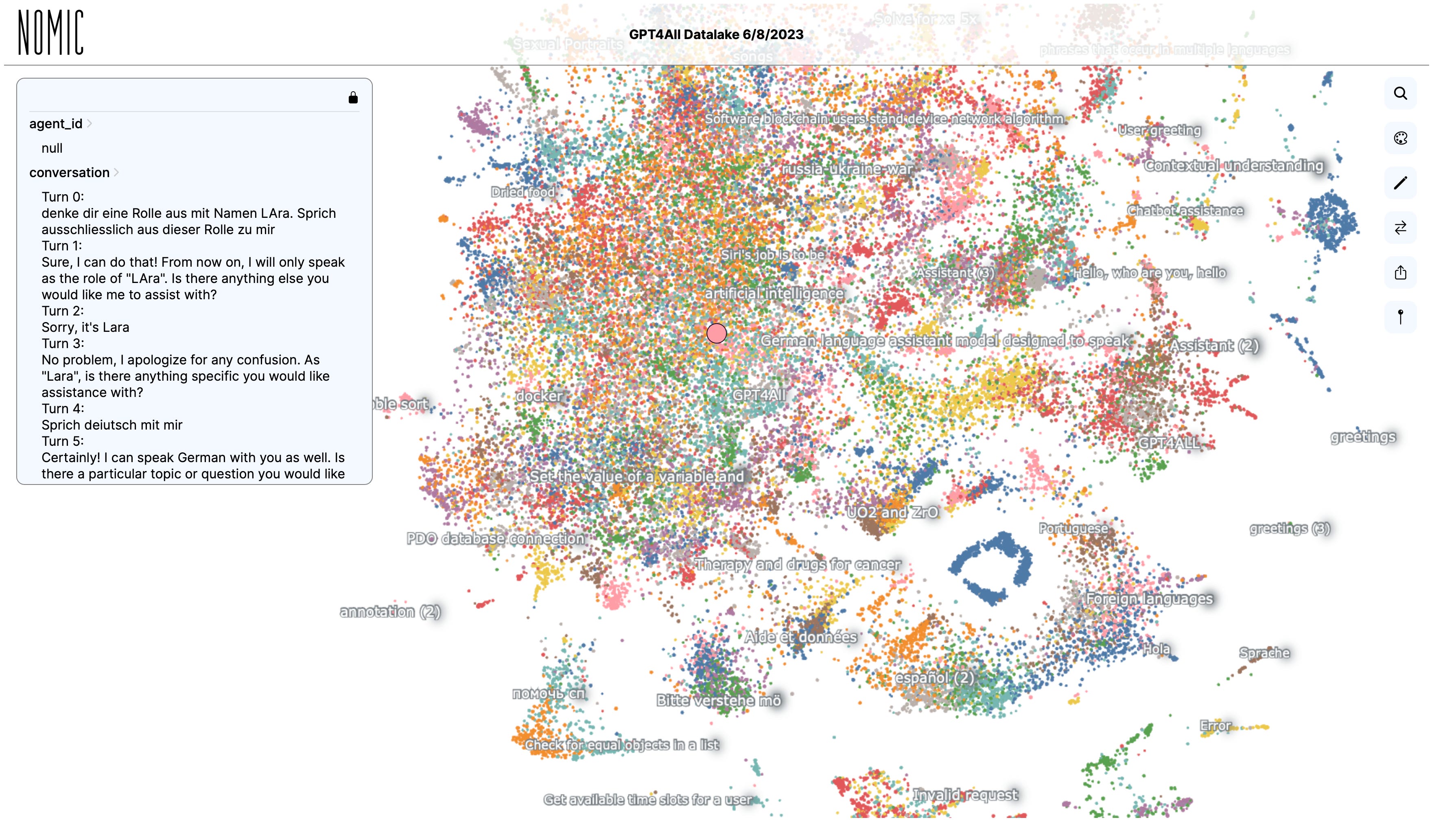

Open Source Datalake sammelt Trainingsdaten

Die sind bereits in der Mache. Ein „Open Source Datalake“ sammelt frei verfügbare Trainingsdaten. Die kann jedermann in GPT4ALL mit der Netzgemeinde teilen. Mitsamt einem Like oder Dislike dazu, wie gut die Antwort war. In der Voreinstellung des Programms ist diese Funktion ausgeschaltet.

Hinter GPT4ALL steckt übrigens nicht nur eine Truppe von Nerds aus der Open-Source-Szene weltweit, sondern unter anderem Nomic AI. Das ist ein Unternehmen aus New York, 2022 gegründet. Einer der Investoren ist Amjad Masad, Gründer von Diensten wie der Programmierhilfe Replit und ehemals Angestellter bei Yahoo, nunmehr auch Investor bei vielversprechenden KI-Diensten wie Perplexity, Runway (Video) und Bluesky (Social Media).

Dritte Variante: Microsofts Azure-Serverdienste

Die dritte Variante für Unternehmen oder Leute, die eine eigene KI einrichten möchten, ist die von Microsoft über deren Azure-Serverdienste. Das wäre ein Unterfangen für die heimische IT- (Pardon:) KI-Abteilung. Abgesehen vom Aufwand fürs Installieren kommen dann monatliche Lizenzkosten ins Spiel, die sich nach der Anzahl der Nutzerinnen und Nutzer bemessen. Und fürs Trainieren mit eigenen Unternehmensdaten entstehen weitere Aufwände und Kosten.

So sind die Drogeriemarktkette dm und Bosch nur jüngste Beispiele einer Entwicklung, die die KI in viele Unternehmen bringen dürfte. Nach einer Grafik im Newsletter „Digitale Transformation“ von Netzoekonom.de ist bei 30,2 Prozent der deutschen Industrie der Einsatz von KI Realität oder geplant. Bei weiteren 38,7 Prozent wird der Einsatz diskutiert.

dm-Vorstoß wird stark diskutiert

Wie stark die Diskussion ist, zeigen die vielen Fragen und Antworten von dm auf ihren LinkedIn-Beitrag zu dmGPT: „Effizienzgewinn ist nicht unser Fokus. Vielmehr möchten wir unseren Mitarbeiterinnen und Mitarbeitern das Arbeitsleben erleichtern, sie im Umgang mit neuen Technologien befähigen und die gesamte Arbeitsgemeinschaft in den Umgang mit künstlicher Intelligenz einbeziehen“, schrieb dort dm. „Den typischen Einsatzzweck gibt es (noch) nicht. Alle dürfen die Anwendung nun im Kontext ihrer Aufgaben ausprobieren und herausfinden, wo der Einsatz Sinn macht und wo eher nicht.“

Comments ()