Bilder bilden weiter

Erste Beispiele beschrieb ich im „Prompt der Woche“ bei der F.A.Z., weitere möchte ich hier veranschaulichen.

Da ist diese Grafik globaler Handelsströme der Welthandelsorganisation. Hochgeladen bei ChatGPT-4V, erkennt die Maschine:

Das bereitgestellte Diagramm zeigt die globalen Handelsströme des Warenhandels im Jahr 2011 in Milliarden Dollar. Hier sind die wichtigsten Informationen aus dem Diagramm:

Regionale Handelswerte (in Milliarden Dollar) für 2011:

Europa: 4.667

Asien/Pazifik: 2.926

Nordamerika: 1.103

Russland/GUS: 754

Nahost: 710

Lateinamerika: 200

Afrika: (Der genaue Wert ist nicht sichtbar, aber es scheint etwas über 150 zu sein)

Interregionale Handelsströme (in Milliarden Dollar):

Beispielsweise handelte Europa Waren im Wert von 906 Milliarden Dollar mit Asien/Pazifik und 476 Milliarden Dollar mit Nordamerika. Es gibt auch andere Handelsströme zwischen verschiedenen Regionen, die durch Pfeile und Zahlen dargestellt werden.

Steigerung der Exporte von 2011 im Vergleich zu 2010 (in %):

Nahost: +37,4%

GUS/Russland: +33,9%

Lateinamerika: +27,4%

Asien/Pazifik: +18,0%

Europa: +17,4%

Afrika: +16,8%

Nordamerika: +16,2%

Weltweit: +19,7%

Das Diagramm gibt einen Überblick über die Handelsbeziehungen und -werte zwischen den verschiedenen Regionen der Welt für das Jahr 2011. Es zeigt auch, wie sich die Exporte dieser Regionen im Vergleich zum Vorjahr gesteigert haben. Die Datenquelle ist die World Trade Organization (WTO).Mehrere Fehler hat diese Auswertung: Der regionale Handelswert für Afrika sei nicht sichtbar, „aber es scheint etwas über 150 [Milliarden Dollar] zu sein“. Die Grafik benennt tatsächlich 77 Milliarden Dollar. Ebenso sind die Warenwerte zwischen Europa und Asien sowie Nordamerika im Text falsch angegeben. Und auch bei den regionalen Handelswerten von Russland und Nahost hat sich die Maschine vertan, offenbar die ähnlichen Ziffern 7 und 1 in der Texterkennung verwechselt.

Es gilt also, höllisch aufzupassen bei den Details.

Dabei dürfte schon helfen, statt einer JPG-Datei künftig ein PDF als Quelle hochzuladen (bisher geht das nicht). Dann entfiele die fehlerbehafte Ziffernerkennung.

Dennoch zeigt diese maschinelle Analyse die Richtung: Richtigerweise hat die KI erkannt, worum es geht. Gelingt es jetzt noch, weniger Fehler einzubauen – und darauf deutet die Entwicklung hin –, so werden neue Erkenntnisse und Interpretationen eine Sache von Sekunden. Die Maschinen erkunden Zusammenhänge.

Worum geht’s hier?

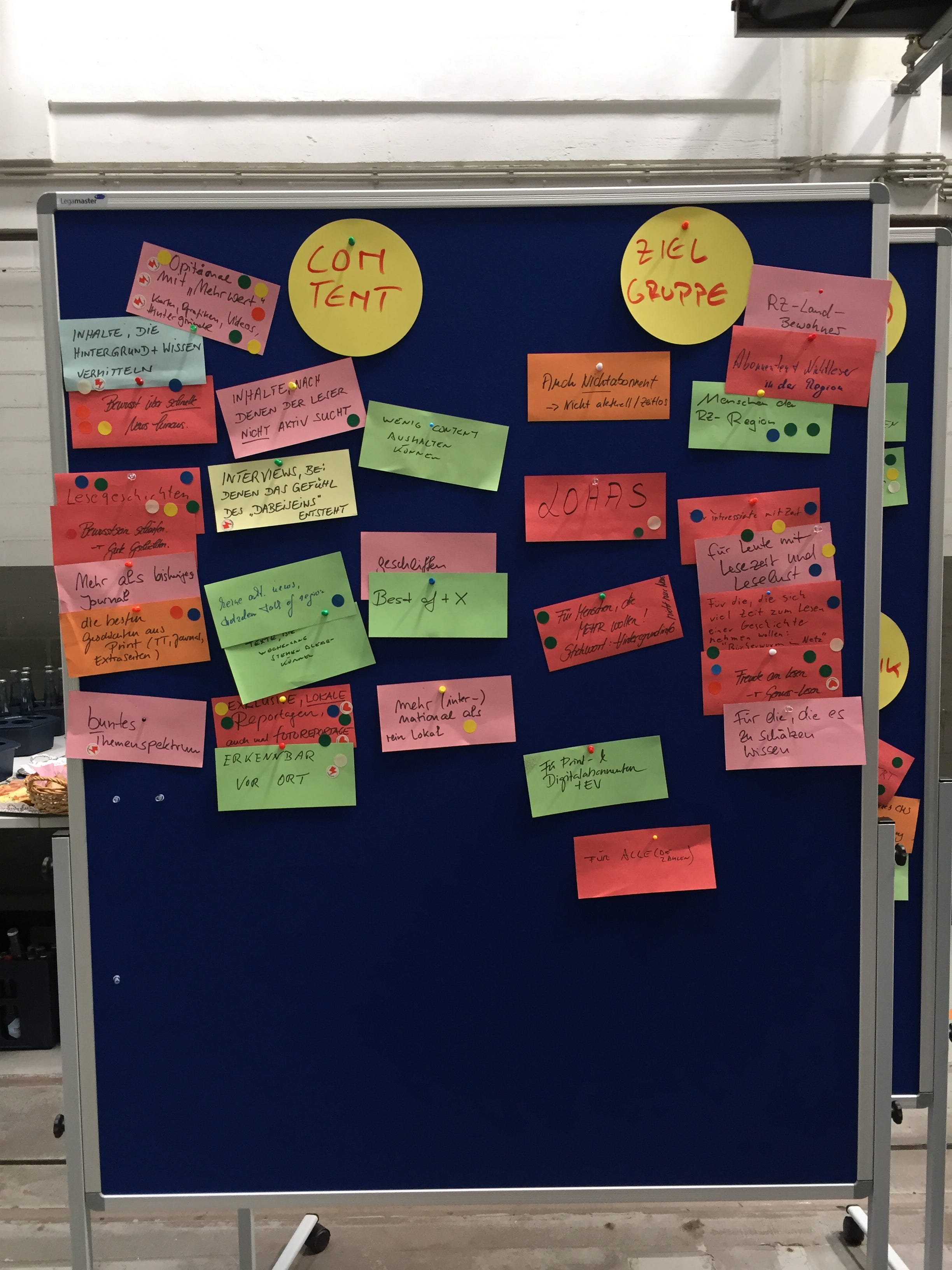

Im Ansatz klappt das mit dem Bild einer Stelltafel: Eine Gruppe von Medienmanagern pappte hier vor ein paar Jahren zu einem Zukunftsthema Klebezettel an die Wand, beschrieben mit Stichwörtern zur künftigen Bezahlschranke eines Online-Angebots. Die handschriftlichen Zettel wurden später von den Teilnehmern mit Punkten beklebt, je nach Einschätzung der Wichtigkeit.

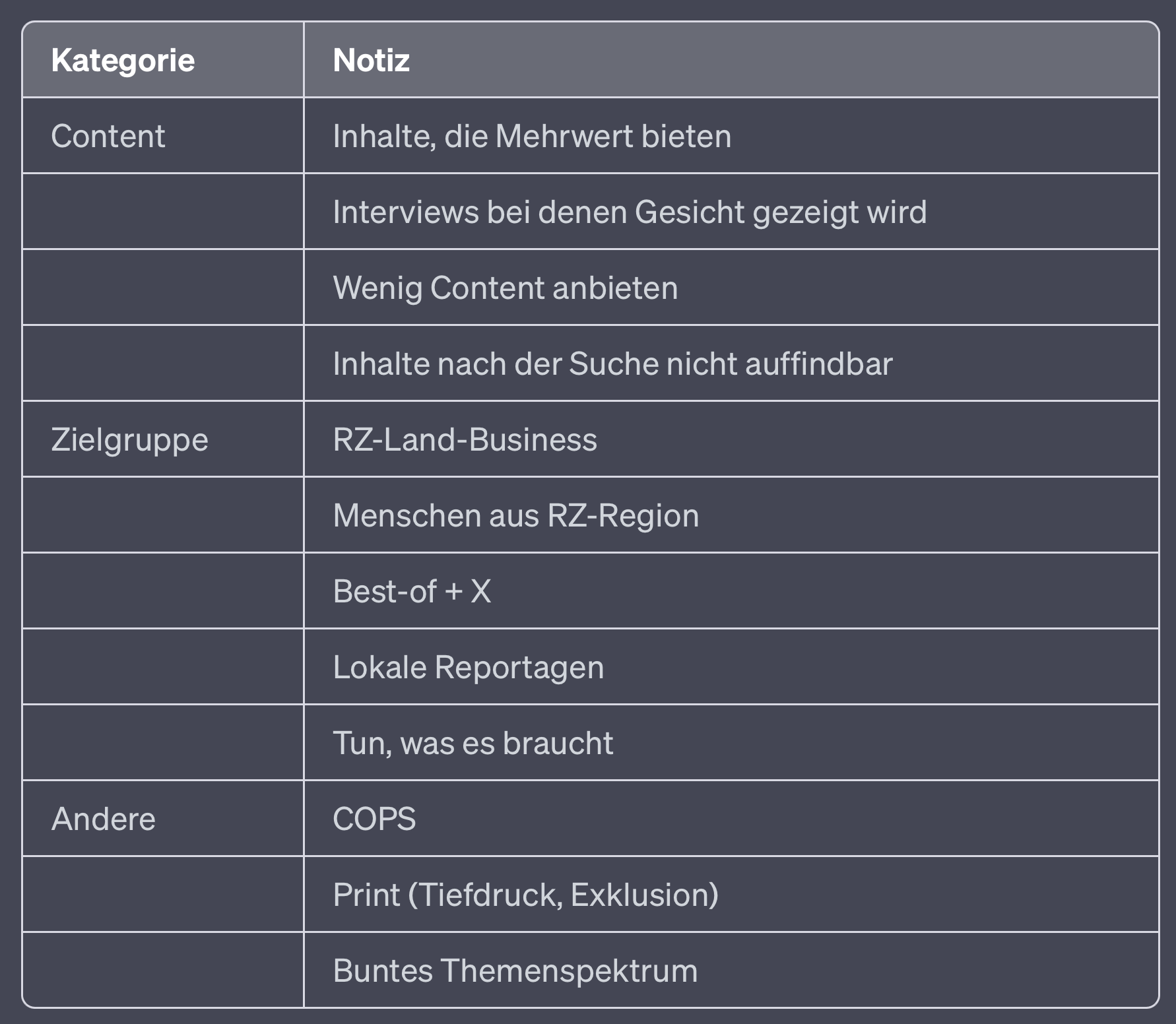

Das hochgeladene Foto der Stelltafel wurde von GPT-4V auf die listige Frage „Worum geht’s?“ ausgelesen und mit drei, vier weiteren folgenden Prompts neu sortiert. Heraus kam eine Tabelle mit den wichtigsten Punkten, soweit die Maschine die Handschrift erkennen konnte. „Es scheint, als handele es sich um ein Brainstorming oder eine Planungstafel zu den Themen ,Content‘ und ,Zielgruppe‘.“

Die Maschine war auch in der Lage, die Anzahl der aufgeklebten Punkte bei einzelnen Klebezetteln auszuzählen. Nicht perfekt, aber es ergab eine zielführende, gute Grundlage.

Die Magie der KI ist dabei erkennbar, aber noch nicht zuverlässig und alltagsüberzeugend. Nicht jede Sauklaue wird erkannt, die Anordnung der Begriffe verrutscht teilweise. Doch auch hier stehen wir einmal mehr am Anfang einer neuen Entwicklung. Der Protokollant sorgt sich um seinen Job, der Kollege mit KI-Kenntnissen macht daraus seinen nächsten Karriereschritt.

Bild-Posts für Social Media bewerten

Für ein drittes Beispiel verweise ich auf den Kollegen Felix Beilharz: Er hat bei LinkedIn Beispiele von Social-Media-Posts untersucht, bei GPT4-V eingespeist und um eine fachkundige Stellungnahme gebeten, sinngemäß: Wie gut ist der Post? Ist die Schrift groß genug? Die Bebilderung hilfreich? Die Maschine entdeckt in dem hochgeladenen Bild unter anderem einen mangelnden „Call to Action“, also eine klare Aufforderung, was der Leser oder die Leser als Nächstes machen sollte.

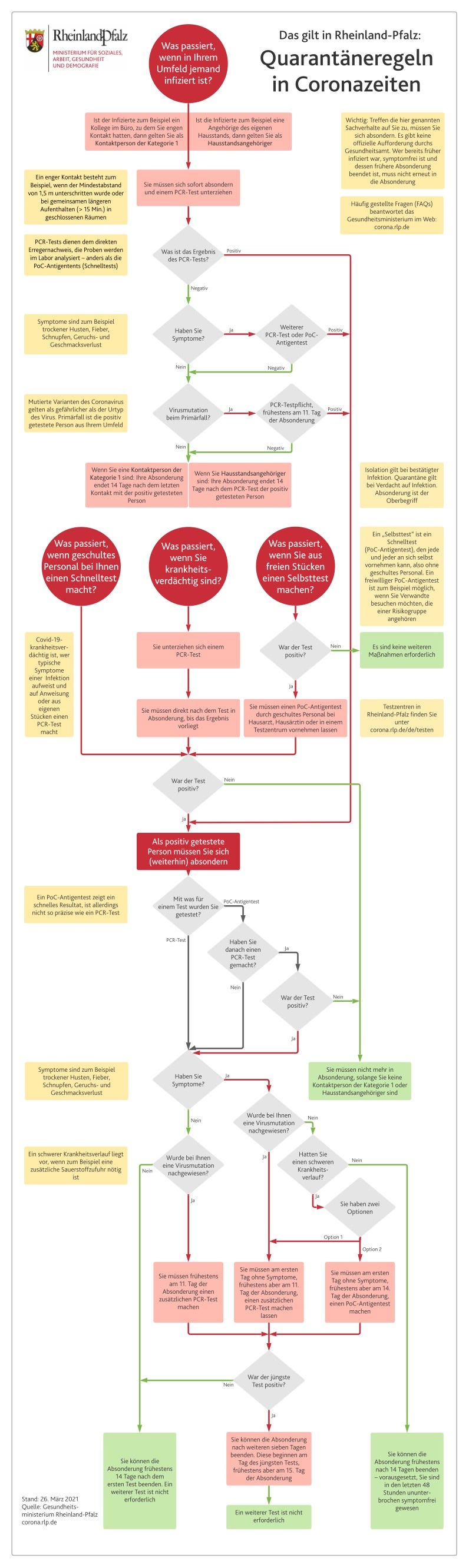

Ein Flussdiagramm interpretieren

Das vierte und letzte Beispiel für den Beginn einer neuen Zeit ist mein Liebling: Die folgende Grafik erstellte ich während der Coronazeit für die Landesregierung. Im extremen Hochformat veranschaulichte sie, wie lange damals jemand in Quarantäne gehen musste, sobald ein Kollege im Büro sich als infiziert krankmeldete.

Dem Diagramm ging ein genüsslicher Austausch mit aufgemalten Entwürfen von Zeichnungen von Fachleuten voraus.

GPT-4V ist in der Lage, dem entstandenen Flussdiagramm zu folgen – und die allgemeinen Regeln auf einen persönlichen Fall anzuwenden.

Der Prompt: Wie lange muss ich selbst in Quarantäne, wenn ich

- a) mit dem infizierten Kollegen am Montag engen Kontakt hatte,

- b) heute Mittwoch ist und

- c) er sich krankgemeldet hat,

- d) ich soeben einen positiven PCR-Test gemacht habe und

- e) selbst Symptome aufweise?

Die Antwort, gekürzt: Da Sie als positiv getestete Person gelten, müssen Sie sich (weiterhin) isolieren. Sie haben zwei Optionen zur Beendigung der Quarantäne. Option 1: Sie müssen sich frühestens am 11. Tag der Isolation erneut einem PCR-Test unterziehen. Wenn dieser Test negativ ist, können Sie die Isolation frühestens am 14. Tag beenden. Option 2: Sie müssen am ersten Tag der Symptome oder am 14. Tag der Isolation einen PCR-Test durchführen lassen.

Das ist bei der Option 2 zwar nicht 100 Prozent exakt, aber nahe dran. Die KI kann künftig auch dabei helfen, Unklarheiten in bestimmten Formulierungen eines solchen Diagramms aufzustöbern. Jetzt stelle man sich das Ergebnis in ein, zwei Jahren vor, wenn auch die Bild-Erkennungs-KI erwachsen wird.

Beim Wiederfinden des Stelltafel-Bildes inmitten von 55.000 Fotos half übrigens eine andere KI: die von Apple Fotos. Sie hat alle diese Bilder untersucht, erkennt Motive, Personen, Objekte und Orte sowie handgeschriebene und gedruckte enthaltene Texte. Die Suche lief nach dem Wort „Content“, das einzige, an das ich mich erinnern konnte. Gerade hat Apple seine iCloud-Funktion für bis zu 12 Terabyte (statt bisher 2 TB) an Daten freigeschaltet.

Künstliche Intelligenz im Videokurs …

Seit vergangener Woche ist die kostenpflichtige Wolf-Schneider-KI draußen. Sie überarbeitet Texte nach den Regeln Schneiders. Ich hatte sie bereits vorab mittesten können und Ergebnisse hier beschrieben.

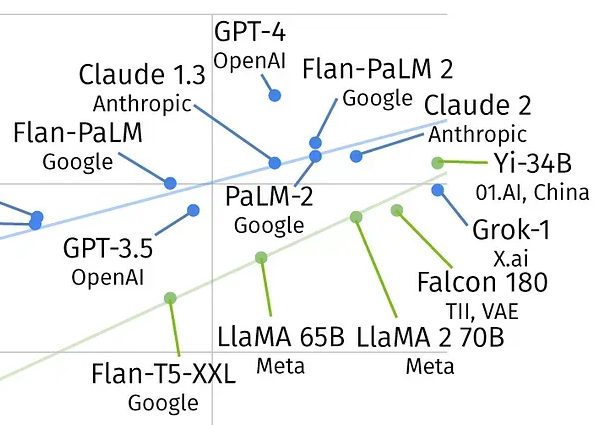

Gemeinsam mit Alessandro Alviani von Ippen Media und den Kollegen der Reporterfabrik gibt es parallel zum Start der WSKI ein kostenloses Online-Seminar zu Künstlicher Intelligenz im Journalismus. Alessandro gibt dazu einen Einblick in die Entwicklung, ich steuere praktische Anwendungen bei.

… und in der Branche

Praktische Lösungen für Publisher stehen auch im Mittelpunkt des Branchenmagazins Kress Pro, das einen bekannten Promptpraktikanten auf den Titel hob. Man sollte ein Geschäftsmodell daraus machen: Die Ausgabe kostet 38 Euro. Chefredakteur Markus Wiegand hat aufgeschrieben, um welche Anwendungen es im Einzelnen geht.

Eine KI-gestützte Analyse seines Postings (als Screenshot) besagt unter anderem: „Das Titelbild zeigt eine Nahaufnahme eines Mannes, der seriös und nachdenklich aussieht.“ So weit, so schmeichelhaft (Danke, Sascha!). Aber zu möglichen Kritikpunkten: „Bildauswahl: Obwohl das Foto des Mannes professionell aussieht, könnte es für einige Betrachter nicht sofort klar sein, wer er ist oder welche Rolle er im Kontext des Magazinthemas spielt.“

Comments ()